Laag crawl budget? Zo optimaliseer je het

Een budget wat elke SEO’er het liefste onbeperkt heeft: het crawl budget. Het is een term die je in SEO-blogs geregeld voorbij ziet komen. Het crawl budget is de hoeveelheid tijd en middelen die Google besteedt aan het crawlen van een site. Moet jij je er druk om maken en moet jij je site optimaliseren voor je crawl budget? In dit artikel kom je erachter!

Laat ik beginnen met je gerust te stellen. Heeft je site niet veel (10.000+) unieke pagina’s die dagelijks veranderen of meer dan één miljoen pagina’s die geregeld veranderen? Dan hoef jij je over het algemeen niet druk te maken om je crawl budget.

Toch is het een veelbesproken onderwerp. SEO’ers denken vaak dat ze een probleem hebben met hun crawl budget omdat hun pagina’s niet gecrawld of geïndexeerd worden.

Crawl rate, crawl demand en crawl budget

Crawl budget is een verzonnen term door de SEO community. Er waren verschillende definities op het internet te vinden waardoor mensen ook vragen stelden richting Google. Om die reden heeft Google later de term crawl budget overgenomen in hun eigen documentatie. Zij spreken niet over één term maar over een crawl budget dat bestaat uit twee onderdelen: crawl rate en crawl demand.

Crawl rate / capacity limit

Een website is gehost op een server. Op het moment dat Google een pagina crawlt maken zij een request naar de server. De server geeft vervolgens een antwoord binnen een bepaalde tijd, dat noemen we de response time. Wanneer Google begint met het crawlen van een website beginnen ze met het opvoeren van het aantal requests totdat ze merken dat de response time hoger wordt. Google wil voorkomen dat je server overbelast wordt en stopt met het verder belasten van je server, een limiet is bereikt. Google spreekt hier dan over een crawl rate limit of crawl capacity limit.

Meer capaciteit op je server en lagere response times kunnen deze limiet verhogen. Verhoog jij je capaciteit? Dan gaat Google het aantal requests stapsgewijs verhogen. Tijdje meer requests: terug naar het oude niveau. Tijdje nog meer requests: weer terug op eerste niveau.

Zo gaan ze weer door totdat ze merken dat een nieuw limiet is bereikt. Het kan ook zijn dat er niks gebeurt, dan is de crawl demand lager dan wat Google kan crawlen.

Crawl demand

Google zet niet altijd alle middelen in om jouw website continu te crawlen, hier speelt de crawl demand een rol. Dat Google urls kan crawlen op jouw website betekent niet gelijk dat Google dat ook wil.

Er zijn vele factoren die bepalen of Google jouw website wel wil crawlen:

- Kwaliteit van de site

- Je autoriteit

- Het aantal wijzigingen op bestaande pagina’s

- De hoeveelheid nieuwe content die je publiceert

Het web is gigantisch groot en het kost Google tijd en geld om te crawlen en alle data op te slaan. Op basis van vele factoren bepalen ze of het nodig is om jouw website vaak te crawlen of niet.

- Maak jij content van slechte kwaliteit? Dan wil Google hier geen tijd aan besteden.

- Publiceer jij weinig nieuwe content? Dan hoeft Google niet zo vaak terug te komen op jouw website om te ontdekken of er nieuwe content is.

- Wijzigt jouw huidige content weinig? Dan hoeft Google niet zo vaak terug te komen om te kijken of er iets gewijzigd is.

Een hogere crawlfrequentie betekent dan ook niet dat je content van betere kwaliteit is. Google kijkt niet naar hoe vaak content vernieuwd is, maar naar de kwaliteit van de content.

Crawl budget

De crawl rate en crawl demand vormen samen het uiteindelijke crawl budget: de hoeveelheid tijd en middelen die Google besteedt aan het crawlen van jouw site.

Hoe test ik of mijn crawl budget laag is?

Testen of je crawl budget te laag is kan door in Google Search Console nieuwe of gewijzigde pagina’s te inspecteren. Heeft Google na één week je pagina nog niet (opnieuw) gecrawld nadat je een aanvraag hebt gedaan? Dan zou een mogelijke conclusie kunnen zijn dat je crawl budget te laag is.

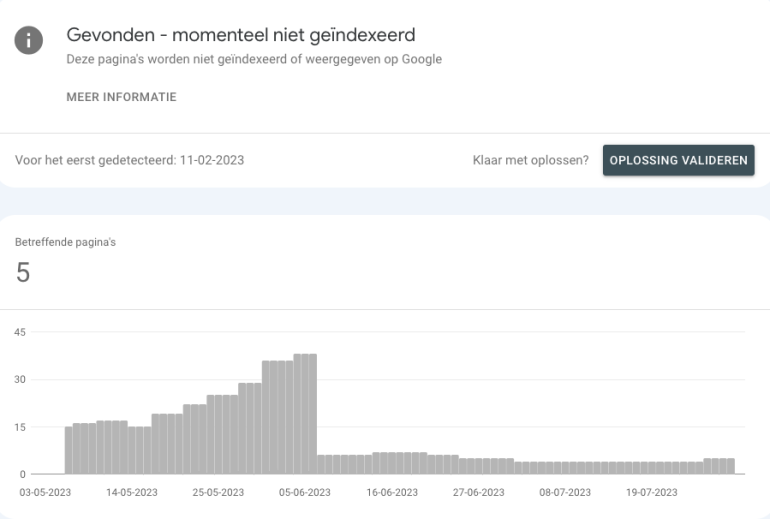

Een andere manier waarop je dit kunt zien is door naar het indexatierapport binnen Google Search Console te gaan. In het rapport kijk je naar de uitgesloten urls en vervolgens naar ‘Gevonden – momenteel niet geïndexeerd’. Is een groot gedeelte van je pagina’s gevonden maar niet geïndexeerd? Dan kun je concluderen dat je crawl budget te laag is. Google heeft al wel de url gevonden maar stelde de crawl uit om te voorkomen dat je server overbelast raakte.

Goed om te kijken of het hier gaat om een groot gedeelte van de site. Is het een kleiner gedeelte en zijn de pagina’s niet belangrijk? Een mogelijke reden kan dan zijn dat Google simpelweg de pagina niet wil crawlen.

Nog een andere manier om te kijken of het probleem aan de crawl rate of crawl demand ligt, is door te kijken naar de crawlstatistieken in Google Search Console. Deze vind je door naar instellingen te gaan binnen en vervolgens op ‘crawlstatistieken’ te klikken.

In dit rapport vind je het aantal requests, de totale downloadgrootte en gemiddelde reactietijd terug. Dit zie je niet alleen in een overzichtelijke grafiek, maar deze is ook op te splitsen per:

- Reactie

- Bestandstype

- Doel

- Googlebot-type

Analyseer de data en vraag je af of je je in de volgende situaties kunt herkennen:

- Het aantal crawlverzoeken is erg laag in vergelijking met het aantal pagina’s op je site.

- Googlebot Smartphone heeft niet het grootste aandeel van alle crawlverzoeken.

- Je publiceert veel content maar Google crawlt in weinig gevallen met als doel vindbaarheid.

Bovenstaande situaties zijn enkele voorbeelden waarbij je crawl rate een probleem kan zijn. Google moet zich, in de meeste gevallen, vooral bezighouden met OK (200) reacties, HTML-bestanden, vernieuwen én vinden als Googlebot Smartphone.

Hoe kan ik mijn crawl budget optimaliseren?

Je crawl budget verhogen is helaas niet een schuifje naar links of rechts schuiven. Heb je door bovenstaande analyses het idee dat crawl budget een probleem voor jouw site is? Dan zijn er enkele dingen die je kunt doen om dit te verhogen.

Servercapaciteit

Merk je dat Google wel wil crawlen maar tegengehouden wordt door de capaciteit van je server? Dan is het goed om eens met je developers te overleggen hoe de capaciteit van je server verhoogd kan worden.

Websitesnelheid optimaliseren

Een andere optimalisatie waarvoor je met je developers om tafel zou moeten, is het optimaliseren van de snelheid van de website. Wanneer pagina’s sneller laden kan Google ook meer pagina’s crawlen.

Robots.txt

Via je robots.txt bestand kun je Googlebot instructies geven om bepaalde urls niet te crawlen. Zo voorkom je dat Google tijd en middelen inzet aan het crawlen van onnodige pagina’s.

Host je je site op een populair cms? Grote kans dat je robots.txt al gevuld is met enkele regels. Wil je toch aan de slag met robots.txt? Lees dan hoe je deze regels kunt opstellen.

Veel voorkomende regels die je kunt opstellen:

- Uitsluiten van sortering bij webshops. Wordt er bijvoorbeeld ?sort= toegevoegd in de url? Dan kun je die uitsluiten: Disallow: /*?sort.

- Uitsluiten van login urls. Login urls willen soms nog weleens lang en uniek zijn. Begint deze bijvoorbeeld met /login/ gevolgd met een unieke waarde? Dan kun je die uitsluiten: Disallow: /login/.

- Uitsluiten van zoekresultaten pagina’s. Word je na het zoeken op een site naar bijvoorbeeld /zoeken?q=zoekterm gestuurd? Dan kun je die uitsluiten: Disallow: /zoeken.

Let op! Gebruik robots.txt wel alleen als je er zeker van bent dat urls onnodig gecrawld worden.

Site hygiëne

Het onderhouden van je site hygiëne is in het algemeen goed om te doen. Door fouten op je site op te lossen kun je je crawl budget ook nog eens optimaliseren.

Vermijd dubbele content

Zijn er meerdere pagina’s die erg op elkaar lijken? Dan bepaalt Google de primaire pagina die uiteindelijk in de index komt.

Om als voorbeeld weer de sortering te nemen. https://www.voorbeeld.nl/categorie/ en https://www.voorbeeld.nl/categorie/?sort=popular zijn praktisch dezelfde pagina’s, Google gaat niet beide pagina’s indexeren. Door het toevoegen van een canonical url op https://www.voorbeeld.nl/categorie/?sort=popular naar https://www.voorbeeld.nl/categorie/ geef je Google twee signalen:

- Ik ben me ervan bewust dat deze pagina verdacht veel lijkt op een andere pagina, die url wil ik in de index hebben. Zo help je Google hiermee.

- Omdat deze pagina dubbel is hoef je die niet zo vaak te crawlen als de canonical url. Google crawlt canonicalised urls minder vaak.

Vermijd (soft) 404’s en 301’s

Tijdens het crawlen van je site kijkt Google naar interne links op je pagina. Staat hier bijvoorbeeld een 404 tussen? Dan kan Google niet verder. Staat hier een 301 tussen? Dan kijkt Google waar deze url naartoe is verhuisd.

Met een programma als Screaming Frog kun je in kaart brengen waar op je site 404’s en 301’s te vinden zijn. Waar ging deze url naartoe en kunnen we deze vervangen voor een link die wél gecrawld moet worden? Zo zorg je ervoor dat Google enkel urls met status code 200 op een site ziet. De kans dat Google deze urls dan gaat crawlen is groter én het is nog fijner voor de gebruiker ook.

TIP! Kijk naar urls die vaker terugkomen, denk hierbij aan bijvoorbeeld redirects in je navigatie of footer. Die interne links kun je makkelijk aanpassen.

Lees ook mijn andere artikel over hoe je Screaming Frog het beste in kunt stellen zodat je alle urls vindt.

Het is ook goed om soft 404’s op te lossen. Dit zijn pagina’s met een 200 status code maar die Google eigenlijk als 404 ziet. Een lijst met urls die Google als soft 404 ziet kun je vinden in het indexatierapport. Hier ga je naar uitgesloten en vervolgens ‘soft 404’s’.

Voorbeeld van een soft 404

Betere content

Je kunt alle SEO-optimalisaties doorvoeren op je site om uiteindelijk betere content te krijgen. Hoe beter de content en hoe meer links naar jouw website, des te hoger de crawl demand vanuit Google is. Een crawl budget probleem betekent niet persé een technisch probleem.

Daarnaast zijn er nog andere sitespecifieke oplossingen die toegepast kunnen worden om een crawl budget te optimaliseren. Twijfel je of je een probleem hebt met je crawl budget? Dan is het aan te raden om dit te laten onderzoeken.

Verzonnen term

Crawl budget is een term die we wel vaak terug zien komen maar niet altijd een probleem is voor websites. Het is een verzonnen term uit de community, Google praat over een crawl rate en een crawl demand. Heb je een probleem met je crawl budget? Dan kun je je crawl budget optimaliseren om ervoor te zorgen dat je pagina’s gecrawld worden.

Dit artikel is gecheckt door het SEO-panel.